La organización de seguridad infantil acusa a Apple de ocultar cifras de CSAM

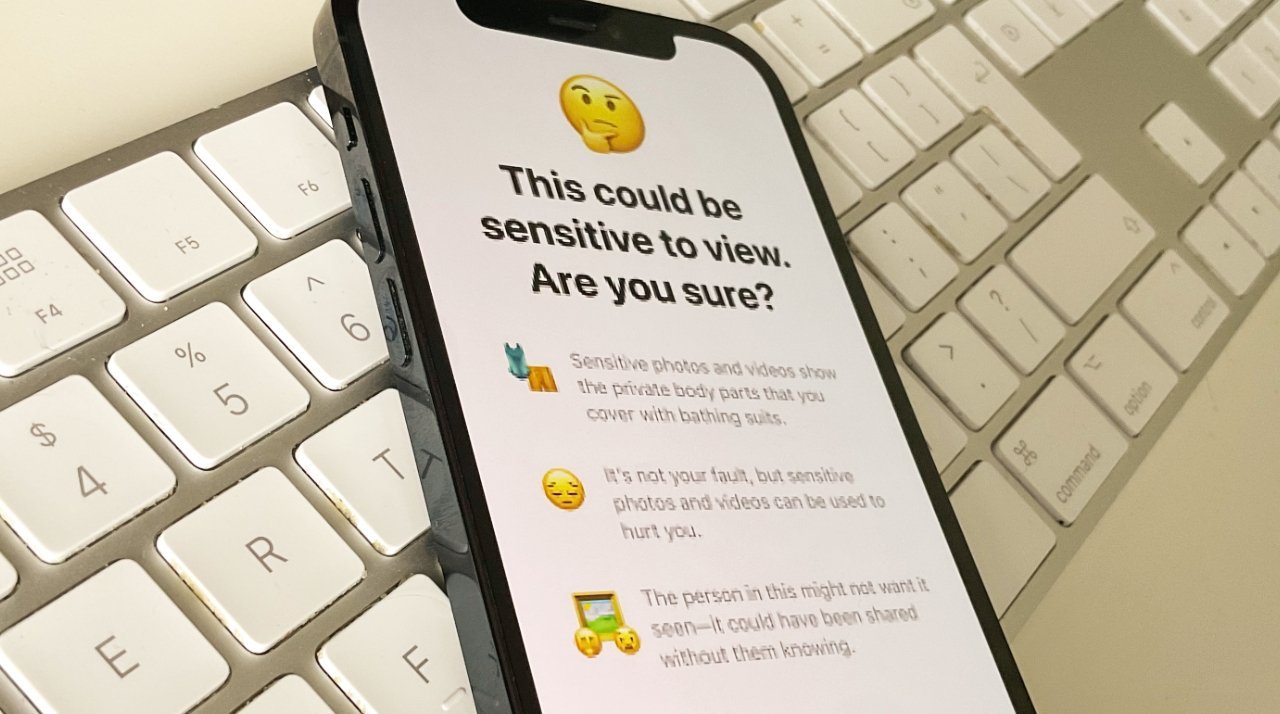

**Apple canceló sus principales propuestas de CSAM pero introdujo funciones como el bloqueo automático de desnudez enviada a niños**

En 2022, Apple abandonó sus planes de detección de Material de Abuso Sexual Infantil (CSAM) luego de acusaciones de que finalmente se usaría para la vigilancia de todos los usuarios. La compañía cambió a un conjunto de funciones que llama Seguridad en la Comunicación, que es lo que difumina las fotos desnudas enviadas a niños.

**La NSPCC del Reino Unido informa más casos de imágenes de abuso en plataformas de Apple de los que Apple ha informado a nivel mundial**

Según el periódico The Guardian, la Sociedad Nacional para la Prevención de la Crueldad Contra los Niños (NSPCC) del Reino Unido dice que Apple está subestimando ampliamente los incidentes de CSAM en servicios como iCloud, FaceTime e iMessage. Todas las empresas tecnológicas de EE. UU. están obligadas a informar casos detectados de CSAM al Centro Nacional para Niños Desaparecidos y Explotados (NCMEC), y en 2023, Apple realizó 267 informes.

**Preocupación por la discrepancia en los informes de abuso infantil de Apple en comparación con otras empresas de tecnología**

«Existe una preocupante discrepancia entre el número de delitos de imágenes de abuso infantil que ocurren en los servicios de Apple en el Reino Unido y el número casi insignificante de informes globales de contenido de abuso que hacen a las autoridades», dijo Richard Collard, jefe de política de seguridad infantil en línea de la NSPCC. «Apple claramente está detrás de muchos de sus pares en la lucha contra el abuso sexual infantil cuando todas las empresas tecnológicas deberían estar invirtiendo en seguridad y preparándose para la implementación de la Ley de Seguridad en Línea en el Reino Unido».

**Comparación de informes de CSAM entre Apple, Google y Meta**

En comparación con Apple, Google informó más de 1,470,958 casos en 2023. Para el mismo período, Meta informó 17,838,422 casos en Facebook y 11,430,007 en Instagram. Apple no puede ver el contenido de los iMessages de los usuarios, ya que es un servicio encriptado.

**Preocupaciones sobre imágenes de CSAM generadas por IA y la respuesta de Apple**

Según informes, algunos expertos en abuso infantil están preocupados por las imágenes de CSAM generadas por IA. La próxima Apple Intelligence no creará imágenes fotorrealistas. En respuesta a las acusaciones, Apple supuestamente se refirió solo a sus declaraciones anteriores sobre la privacidad del usuario en general.

En conclusión, la polémica en torno a los informes de abuso infantil en las plataformas de Apple destaca la importancia de abordar de manera efectiva y transparente este grave problema. Es fundamental que las empresas tecnológicas trabajen en estrecha colaboración con las autoridades para garantizar la seguridad de los niños en línea y proteger su bienestar.