Apple atrapado entre la espada y la pared al lidiar con la pornografía AI Título SEO en español: «Apple enfrenta dilema al tratar con la pornografía AI»

**Altered image found in face swap ad: El dilema de las aplicaciones de doble uso en Apple**

En la era digital en la que vivimos, el avance de la tecnología ha traído consigo una serie de desafíos éticos y de seguridad que las empresas deben abordar. En este sentido, Apple se ha enfrentado a un problema recurrente con las aplicaciones de «doble uso», que parecen inofensivas a simple vista pero que permiten a los usuarios crear contenido pornográfico falso, también conocido como «deepfake».

**El control de Apple en la App Store y los límites de su poder**

Apple se enorgullece de su riguroso control sobre la App Store, que incluye la prohibición de aplicaciones pornográficas. Sin embargo, existe un vacío en este control que permite que algunas aplicaciones ofrezcan funciones que los usuarios pueden fácilmente utilizar de manera inapropiada, sin que Apple sea consciente de ello.

Según un informe de 404 Media, Apple se enfrenta a un problema de «doble uso» en aplicaciones que ofrecen la posibilidad de intercambiar caras. Aunque esta función parece inocente en un principio, los usuarios la utilizan para intercambiar caras en contenido pornográfico, incluso utilizando imágenes de menores.

**El descubrimiento de una aplicación de intercambio de caras en un anuncio**

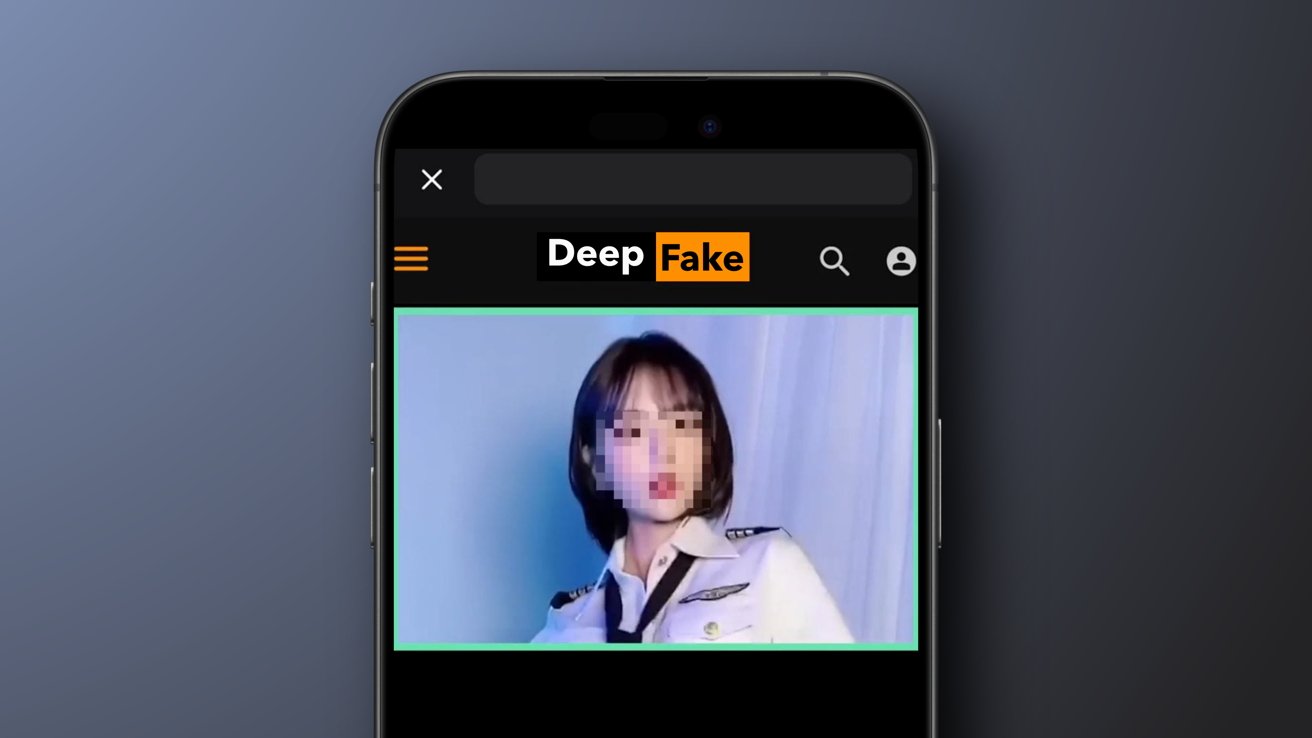

El problema se hizo evidente cuando un reportero encontró un anuncio de pago en Reddit de una aplicación de intercambio de caras. Dado que las aplicaciones de intercambio de caras suelen ser fáciles de encontrar y a menudo gratuitas, resultaba sospechoso que una de estas aplicaciones estuviera promocionándose a través de un anuncio de pago.

La aplicación ofrecía a los usuarios la posibilidad de intercambiar cualquier cara en videos de su «sitio web favorito», con una imagen que sugería a Porn Hub como una de las opciones. Aunque Apple no permite aplicaciones relacionadas con el contenido pornográfico en la App Store, algunas aplicaciones que permiten a los usuarios generar su propio contenido a menudo presentan imágenes y videos de este tipo como un vacío legal.

**La necesidad de regular las aplicaciones de «doble uso»**

Este no es el primer caso en el que aplicaciones que parecen inofensivas logran pasar la revisión de la App Store y ofrecen un servicio que viola las directrices de Apple. Aunque no es tan evidente como convertir una aplicación para niños en un casino, la capacidad de generar imágenes íntimas no consentidas claramente no estaba en el radar de Apple.

Las características de inteligencia artificial en las aplicaciones pueden crear deep fakes increíblemente realistas, por lo que es fundamental que empresas como Apple tomen medidas para evitar estos problemas. Aunque no pueden evitar por completo estos casos de uso, pueden implementar políticas claras que se apliquen en la revisión de aplicaciones, como directrices y reglas específicas sobre la generación de imágenes pornográficas.

**Conclusión y llamado a la acción**

En resumen, Apple debe tomar medidas más estrictas para evitar que las aplicaciones de «doble uso» se cuelen en la App Store y violen sus directrices. Es fundamental que la empresa se adelante a estos problemas y establezca normas claras que protejan la seguridad y la privacidad de los usuarios.

Es necesario que Apple refuerce su proceso de revisión de aplicaciones y se asegure de que todas las aplicaciones cumplan con sus estándares éticos y de seguridad. De lo contrario, corre el riesgo de perder el control sobre la App Store y poner en peligro la confianza de sus usuarios.